- Door

- Arnout Veenman

- geplaatst op

- 2 juli 2010 08:05 uur

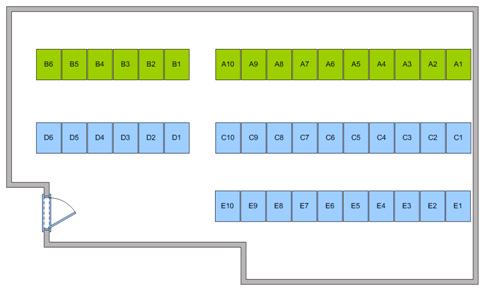

Mach-IT.NET heeft een klein regionaal datacentrum geopend onder de naam Datacenter Dongen. Sinds april 2010 is het datacentrum operationeel en vanaf 12 juli 2010 verwelkomt het datacentrum de eerste klanten. Datacenter Dongen beschikt over een netto datavloer van 100m2 en biedt ruimte aan 45 racks.

Mach-IT.NET heeft een klein regionaal datacentrum geopend onder de naam Datacenter Dongen. Sinds april 2010 is het datacentrum operationeel en vanaf 12 juli 2010 verwelkomt het datacentrum de eerste klanten. Datacenter Dongen beschikt over een netto datavloer van 100m2 en biedt ruimte aan 45 racks.

Alle racks zijn voorzien van een eigen noodstroomvoorziening. In elk rack bevindt zich een ATS (Automatic Transfer Switch) die een aansluiting heeft op de netspanning en de generator. Daarnaast heeft elk rack ook een eigen UPS om kortstondige stroomuitval op te vangen en het rack van spanning te blijven voorzien zolang de generator nog niet is opgestart. De elektrische infrastructuur van het datacenter heeft een maximale capaciteit van 175 Kilowatt. Ook heeft het datacentrum een dieselgenerator.

Datacenter Dongen maakt gebruik van het metro netwerk van EuroFiber. In samenwerking met EuroFiber zijn er meerdere verbindingen naar Amsterdam gerealiseerd. Op locaties in Amsterdam wordt verbinding gemaakt met diverse netwerken, waaronder; Signet, Netrouting en Grafix Internet. Al deze netwerken bieden naast IPv4- ook IPv6-connectiviteit.

Alle ruimtes zijn voorzien van bewegingsmelders welke bij detectie verlichting en camerabewaking inschakelen. Het toegangssysteem maakt het mogelijk dat klanten 24 uur per dag zelfstandig het datacentrum in kunnen.